عند الحديث عن ملف Robots txt فنحن بصدد توضيح بعض الأسئلة والإجابة عنها في البداية، عند القيام بإنشاء موقع إلكتروني، ما الذي تستهدفه بالتحديد؟ تحسين محركات البحث مثلاً أم تعزيز الظهور في الصفحات الأولى أم تحقيق ترتيب أعلى في جوجل، والبديهي، أنك تستهدف كل هذه الأمور في آنٍ واحد، ولكن كيف يتم ذلك؟

الموضوع ببساطة أن تقوم بتسريع عملية الفهرسة أو أن تخبر محرك البحث بما تريد الزحف عليه وما لا تريد الزحف عليه أو بالأحرى ظهور الصفحات المهمة، وفهرسة الصفحات غير المهمة، وهذا لن يتم بدون ملف Robots txt فما الذي يعنيه؟ وما آلية عمله؟ وما الذي يجعله مهماً لتلك الدرجة؟ هذا ما سوف نوضحه في هذا المقال.

ما هو ملف Robots txt؟

ملف Robots txt عبارة عن ملف يتضمن إرشادات ونصوص معينة من خلالها تخبر محرك البحث بما تريد الزحف عليه، وما لا تريد الزحف عليه سواء صفحات أو أقسام محددة، وتلتقط روبوتات محركات البحث هذه التعليمات من خلال الأكواد التي تم وضعها في الملف النصي للحد من البيانات أو الصفحات أو الأقسام ذات الأهمية الأقل، ومن ثم يسهم هذا الملف في إبراز النتائج المفيدة والمجلدات ذات الأهمية.

ما هي أهمية ملف Robots txt؟

إذن ما الذي يجعل ملف Robots txt مهماً لهذه الدرجة؟ إن ما يقوم به هذا الملف يتضمن الإدارة النشطة لكافة الأنشطة الزاحفة التي تضعف موقعك على محركات البحث بما تظهره في العرض العام للمستخدمين، لذا تكمن أهميته في الآتي:

1- تعزيز ميزانية الزحف

قد تواجه صعوبة كبيرة عند فهرسة جميع الصفحات دفعة واحدة، وذلك بسبب المشاكل في ميزانية الزحف الخاصة بك، فإن تجاوزت الصفحات ميزانية الزحف، فسوف تواجه مشكلة توافر العديد من الصفحات غير المفهرسة على موقعك، وهذا يعني أن هذه الصفحات لن يتم تصنيفها، لذا يمكنك من خلال برنامج Googlebot إنفاق المزيد على الصفحات المهمة.

2- منع الصفحات المكررة وحظرها

من المؤكد أنك لست بحاجة لفهرسة جميع الصفحات على موقعك، ولا تريد لمحركات البحث أن تزحف عليها مثل صفحات تسجيل الدخول، وصفحات نتائج البحث الداخلية، فبعض هذه الصفحات يجب أن تكون موجودة بالفعل، وليس هناك أي داعي لفهرستها، وعند هذا الحد، تستطيع استخدام ملف Robots txt لحظر هذه الصفحات من برامج الزحف.

3- إخفاء الموارد

توجد بعض الموارد التي ترغب في أن يستبعدها Google في الزحف مثل: ملفات PDF والصور ومقاطع الفيديو، وفي حال أردت الحفاظ على خصوصية هذه الموارد، فإن ملف الروبوت سوف يمنع فهرستها.

اقرأ أيضاً عن: تحسين محركات البحث SEO

كيف يعمل ملف Robots.txt؟

إن الكيفية التي يعمل بها ملف الروبوت تخبر محركات البحث بعناوين الـ URL سواء التي يُراد الزحف عليها أو تلك التي لا يمكنها الزحف عليها، وهنا يظهر أن محركات البحث تقوم بوظيفتين رئيسيتين:

1- الزحف إلى موقع الويب لاكتشاف المحتوى.

2- فهرسة المحتوى لعرضه على المستخدمين ممن يبحثون عن المعلومات.

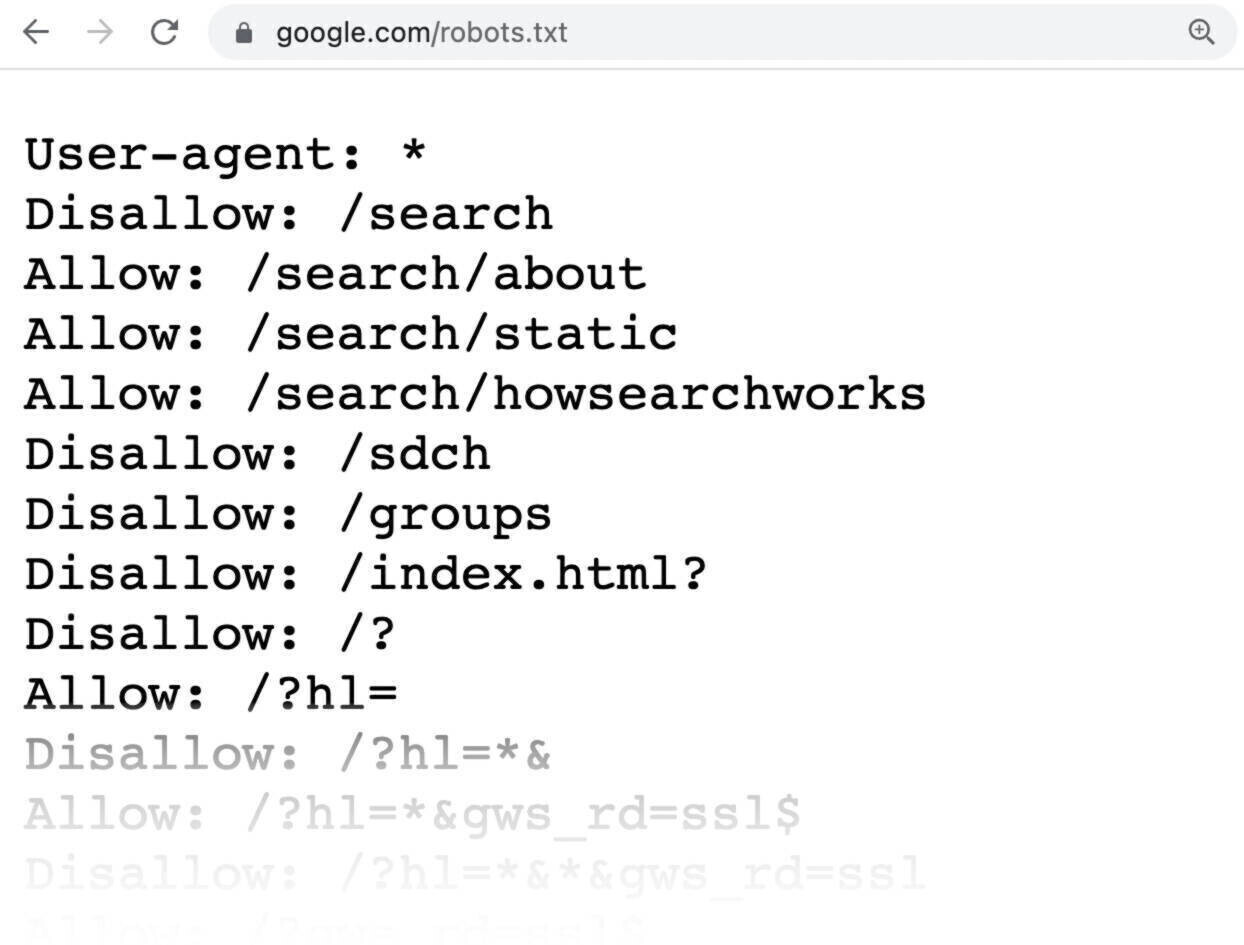

ومتى بدأ الزحف، تكتشف الروبوتات كافة الروابط وتتبعها بشكل انتقالي عبر مليارات المواقع والروابط، وبمجرد الوصول إلى موقع ما من ضمن المواقع، تبدأ الروبوتات بالبحث عن ملف Robots txt وفي حال العثور على واحد، فسوف يتم قراءة هذا الملف قبل البدء بأي عملية أخرى، وهذا هو شكل Robots txt.

اقرأ أيضاً عن: السيو التقني Technical SEO

ما هي محتويات ملف robots.txt؟

يحتوي ملف Robots txt على:

- مجموعة من التوجيهات.

- وهذه المجموعات لكل منها وكيل مستخدم.

- بالإضافة إلى تعليمات السماح أو عدم السماح.

والملف نفسه يتكون مجموعة من الأكواد والسطور البرمجية، كما يحتوي على أسطر أخرى بمثابة أوامر برمجية، مثل:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://Your_Domin/sitemap.xml

وهذه المحتويات تشمل:

- توجيه وكيل المستخدم: وهو السطر الأول من كتلة الأوامر لتحديد الزاحف المراد التعامل معه.

- توجيه عدم السماح: وهو السطر الثاني لتحديد الموارد التي لا يستطيع الزاحف الوصول إليها.

- توجيه السماح: والذي يسمح لمحركات البحث بالزحف لصفحة معينة أو دليل فرعي.

- توجيه ملف Sitemap: والذي يخبر محركات البحث بمكان العثور على خريطة XML.

- توجيه تأخير الزحف: وهو الذي يمنع برامج الزحف من إرهاق الخادم.

كيف تجد ملف Robots.txt علي موقعك؟

يسأل البعض عن كيفية البحث عن ملف Robots.txt وهذا الملف كأي ملف آخر على موقع الويب يمكن الوصول إليه على الخادم الخاص بك، حيث يمكنك رؤيته من خلال كتابة عنوان URL للصفحة الرئيسية، وتضيف إليه Robots.txt مثل: https://g-dart.com/Robots.txt ومن الضروري أن يكون ملف Robots txt موجود داخل النطاق الخاص بك وإلا سوف تفترض برامج الزحف أن ليس لديك واحد بالفعل.

اقرأ أيضاً عن: السيو الخارجي Off Page SEO

كيفية إنشاء ملف Robots.txt؟

يمكنك إنشاء ملف robots.txt باتباع الخطوات التالية:

1- إنشاء ملف robots.txt وتسميته

باستخدام أي متصفح أو محرر نصوص، قم بفتح مستند txt وتسمية روبوت المستند، ويجب أن يكون اسمه robots.txt لبدء كتابه الأوامر، ولكن ابتعد عن استخدام معالج النصوص لأنه يحفظ الملف بطريقة يمكنها إضافة حروف عشوائية.

2- إضافة القواعد إلى ملف robots.txt

كما ذكرنا يتكون ملف Robots txt من مجموعة من التوجيهات، لكنها منها وكيل مستخدم ومجموعة من السطور بها تعليمات معينة، وهذه المعلومات تتمثل فيمن تنطبق عليه المجموعة، والملفات التي يمكن الوصول إليها، وكذلك الملفات التي يصعب الوصول إليها، وخريطة الموقع Sitemap. والملاحظ أن برامج الزحف تتجاهل الأسطر غير المتطابقة مع التوجيهات، فعلى سبيل المثال: إذا أردت منه جوجل من الزحف لدليل Clients وسوف تبدو المجموعة كالتالي:

User-agent: Googlebot

Disallow: /clients/

وإذا أردت تضمين المزيد من التعليمات، فيجب أن يتم الأمر في سطر منفصل، مثل:

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for- google/

وعند الانتهاء، يتم الضغط على Entre مرتين لإنشاء مجموعة جديدة من التوجيهات وصولاً إلى إضافة خريطة الموقع، ثم يتم حفظ الملف.

3- تحميل ملف Robots txt على الموقع

بعد حفظ الملف على جهاز الكمبيوتر، يتم رفعه على الموقع ليكون متاحاً لمحركات البحث الزاحفة، وعلى الرغم من عدم وجود أداة تساعد على هذه الخطوة إلا أن تحميل الملف يعتمد على بنية الموقع والاستضافة، لذا يمكنك التواصل مع مزود الاستضافة ليوضح لك طريقة تحميل الملف، وفي النهاية تأكد أن بإمكان الجميع رؤيته وقراءته بعد تحميله.

4- اختبار ملف Robots txt

وهذه هي الخطوة الأخيرة التي عن طريقها تبدأ في اختبار ملف Robots txt للتأكد إذا ما كان صحيحاً أم لا.

اقرأ أيضاً عن: ريادة الأعمال الرقمية Digital Entrepreneurship

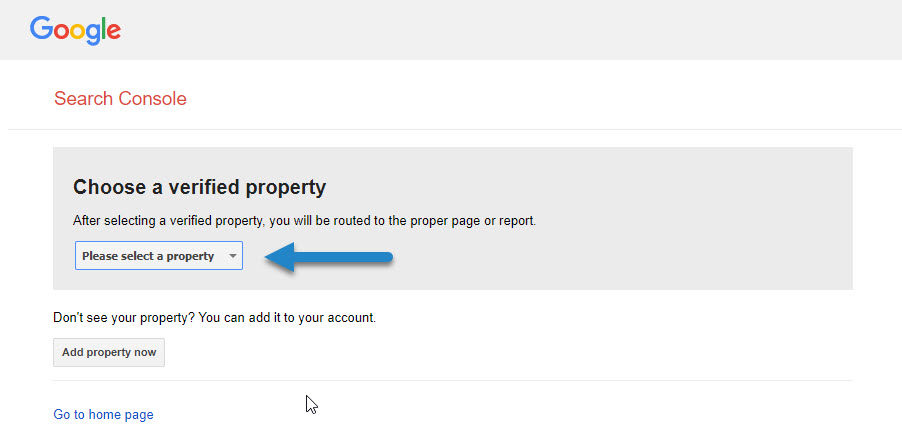

كيفية اختبار ملف robots txt والتأكد من صحته؟

تستطيع اختبار ملف Robots txt من خلال بعض أدوات Google مثل: Google Search Console كما هو موضح في الصور أدناه.

أفضل ممارسات ملف robots.txt؟

توجد بعض الممارسات التي يجب وضعها في عين الاعتبار عند إنشاء ملف Robots.txt ومنها:

- يجب أن يكون لكل توجيه سطر جديد.

- يتم استخدام وكيل المستخدم مرة واحدة.

- استخدام أحرف البدل (*) عند توضيح الاتجاهات.

- استخدام ($) في نهاية العنوان.

- استخدام (#) لإضافة التعليقات.

اقرأ أيضاً عن: السيو الداخلي On-Page SEO

هل يمنع ملف robots.txt الوصول إلى الصفحات المختارة نهائيًا؟

حسناً، هذا القسم يمكن عرضه كالتالي:

أولاً: لا يمنع ملف Robots txt الوصول إلى صفحاتك نهائياً على محركات البحث، بل تزحف روبوتات محركات البحث إلى الصفحة قهراً ورغماً عن الملف نفسه لأن هناك احتمالية أن تشير إحدى المواقع الأخرى إلى الصفحات المحظورة في الملف عبر الروابط.

ثانياً: يمكن حل هذه المسألة ببساطة، وذلك بالقيام بإنشاء بيانات وصفية وفقاً لـ noindex بأن تذهب إلى الإعدادات المتقدمة في الصفحة المراد فهرستها، وبعد فتح هذا الخيار، اضغط على No الموجودة تحت جملة “يجب أن تتبع محركات البحث الارتباطات الموجودة على هذه المقالة”.

التعامل مع أخطاء ملف Robots.txt

عند التعامل مع ملف الروبوتات، قد تواجه مجموعة من الأخطاء التي تؤثر على كيفية وصول محركات البحث إلى محتوى موقعك، ومن أبرز الأخطاء الشائعة هي:

- أخطاء في الصياغة: قد تحدث أخطاء في كتابة القواعد داخل الملف، وهذا يؤدي إلى عدم تطبيق التعليمات بشكل صحيح، لذا تأكد من استخدام توجيه محركات البحث بشكل دقيق واتباع التنسيق الصحيح.

- فشل في تحديد القواعد: في بعض الأحيان، قد يكون من الصعب فهم القواعد التي تم تعيينها في ملف robots.txt، لذا استخدم تعليمات الزحف دقيقة لتجنب أي لبس.

- الملف غير موجود: إذا لم يكن لديك ملف robots.txt على موقعك، قد تواجه مشكلات في إدارة الزحف، وهنا ننصح بالتأكد من إنشاء الملف وتحديثه بانتظام.

- ولحل هذه المشاكل، استخدم أدوات مثل “أدوات مشرفي المواقع” من جوجل للتحقق من صحة ملف robots.txt وتصحيح أي أخطاء موجودة.

تأثير ملف Robots.txt على SEO

ملف robots.txt يلعب دورًا مهمًا في تحسين محركات البحث (SEO) من خلال:

- تحسين إدارة الزحف: بفضل “إعدادات الروبوتات”، يمكنك توجيه محركات البحث لترك بعض الصفحات التي قد لا تكون ذات فائدة كبيرة في تصنيف الموقع.

- تسريع عملية الزحف: باستخدام “توجيه محركات البحث” بشكل فعال، يمكنك تحسين سرعة الزحف إلى الصفحات الهامة وزيادة سرعة الفهرسة.

- تحسين جودة الفهرسة: يساعد في ضمان أن محركات البحث تركز على المحتوى ذي الجودة العالية بدلاً من الصفحات غير المفيدة، وهذا يؤثر إيجابياً على ترتيب موقعك في نتائج البحث.

أفضل أدوات لتحليل ملف Robots.txt

توجد العديد من الأدوات التي يمكن أن تساعدك في تحليل وتحسين “ملف الروبوتات” للتأكد من أدائه :

- أداة تحليل Robots.txt من جوجل: تتيح لك هذه الأداة فحص ملف robots.txt على موقعك والتحقق من أي مشكلات في “تعليمات الزحف”.

- أداة Robots.txt Checker: أداة مجانية عبر الإنترنت تساعد في تحليل “إعدادات الروبوتات” وإيجاد أي أخطاء أو تحسينات.

- سيو موكيت: أداة لتحليل “توجيه محركات البحث” وتقديم تقارير تفصيلية حول كيفية تأثير ملف robots.txt على SEO.

والآن، وبعد الاطلاع على ملف Robots txt وأهميته في تحسين محركات البحث وتعزيز الظهور، تستطيع ببساطة التواصل مع شركة G-Dart لخدمات تحسين محركات البحث عند مواجهة أي عطل فني أو مشكلة في ملف الروبوت لمعالجتها على الفور، كما تقدم الشركة حلول تسويقية تسهم في تطوير أعمالك والتغلب على منافسيك.